在本文中,看看什么是网络抓取,看看用机器人还是人性化的效果更好。

本文最初由Toni Matthews-El撰写。

要说互联网上有很多数据是一种轻描淡写的说法。预计到2020年,“数字宇宙” 将拥有大约40万亿千兆字节或40 兆字节的信息。从一个角度来看,一个零字节有足够的数据来填充大约是曼哈顿大小五分之一的数据中心。

有了如此众多的可用信息来进行分析,有意义的是,与收集数据相关的许多任务留给了人工智能。漫游器可以以惊人的速度爬行网页,并根据需要提取尽可能多的相关信息。尽管许多数据科学家和市场营销人员以完全符合道德的方式访问和使用此信息,但不幸的事实是,在线AI的日益普及带来了越来越多的污名。

由于好莱坞电影和科幻故事的间接结果而忽略了大部分负面因素,这是很容易的,因为人工智能在最好的情况下需要警惕。但是,某些Web用户使用不道德的漫游器的后果意味着,存在一些打击活动,甚至影响那些专业且真诚地处理数据的人。

对于许多专业人员,尤其是AI来说,Web抓取仍然是必不可少的工具。但是,与机器人相关的污名怎么办?

首先,什么是Web爬网?

对于刚刚加入对话的人,网络抓取的行为应理解为数据提取。尽管数据科学家和其他专业人员使用抓取来分析非常复杂的数字信息堆栈,但是从网站复制和粘贴文本的行为本身也可以被视为简单的抓取形式。

但是,即使您可以访问网站的每个部分,也有太多可用的信息,仅从那个来源收集数据就可能花费很长时间。在大多数情况下,Web抓取留给AI,然后人类取回检索到的数据并针对各种目的进行彻底分析。但这虽然为Web爬虫程序提供了极大的便利,但网站所有者和旁观者仍然非常担心以这种方式广泛使用AI。

使用Bot进行网页爬取更好吗?

由于要分析的信息太多,因此似乎毫不费力地转向人工智能(AI)来收集数据。实际上,Google本身是向感兴趣的各方提供Web抓取工具的最受信任的来源之一。例如,您可以使用其数据集搜索引擎快速访问被视为免费可用的数据。您甚至可以自定义搜索以了解该信息是否可用于商业用途。只需几秒钟。

如果Google AI无法如此有效地检查其范围内的每个网站以获取相关数据,那么这将是不可能的。这是使用AI以纯道德的方式为研究或业务收集有用信息的完美示例。可用性的速度也证明了“机器人”如何使执行网络抓取任务如此容易。

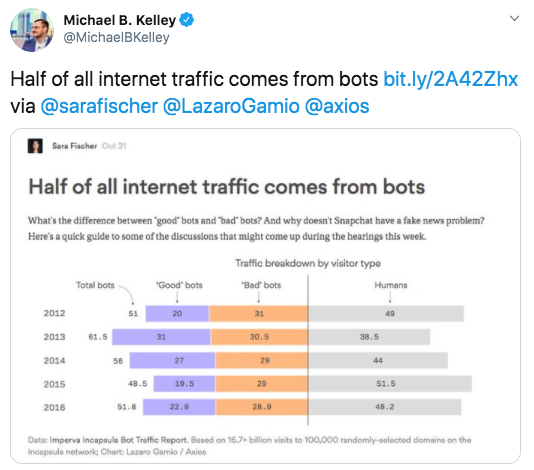

话虽这么说,很难忽略AI流量变得如此普遍的含义,以至于占到Internet流量的一半以上。

机器人交通报告

尽管有些人发现AI占互联网流量的大部分令人担忧,但由于AI流量的大部分由“不良机器人”组成,这一问题变得更加严重。即使在抓取意图良好且方法合乎道德的情况下,AI污名也不可避免。

使用机器人来处理海量数据是一个逻辑步骤。除了AI之外,在抓取时考虑其他重要工具也很重要。

代理如何提供帮助

如此处所述,在Web抓取时使用代理有多个优点,即匿名性。例如,如果您想研究一个竞争品牌并使用该信息确定如何最好地改善自己的公司,则可能不希望知道您访问了他们的网站。在这种情况下,使用代理访问和检查数据而不会泄露您的身份非常好。

在深入探讨之前,下面是有关代理服务器的快速回顾:

- 代理服务器旨在充当用户和Web服务器之间的中间人。

- 它们的功能多种多样:个人和公司均可使用它们来满足特定需求。

- 代理的一种常见用法与Web抓取相关:使用代理服务器,可以规避网站管理员设置的限制并大规模收集数据。

但是,为什么要首先设置这些限制?这些数据不是在网络上免费提供的吗?是的-对于人类用户。这是一个典型的示例:价格汇总商的整个业务模型都是围绕准确的信息构建的;即,提供以下问题的明确答案:“我可以在哪里以最低价格购买产品X?”

尽管这对客户来说是一个节省钱的好机会,但是供应商对其他公司窥探数据并不感到兴奋:聚合商的Web爬行软件(通常称为“机器人”或“蜘蛛”)在网站上带来了额外的负担。因此,如果网站管理员怀疑给定的网络活动不是由真正的用户进行的,则限制访问其网站的情况并不少见。

代理的另一个实际用途是规避审查禁令。顾名思义,住宅代理可以让您以X国(无论您喜欢哪个国家)的真实用户身份出现。住宅代理的需求很简单:(可疑)机器人活动通常来自一组国家,因此,即使来自这些国家/地区的真正用户也经常会遇到地域限制。

另外,当您试图从出于政治原因而保留的来源中收集数据时,代理的使用特别有帮助。在网络抓取时有很多使用代理的方法,但是为了在数字社区中建立信任,我们建议坚持使用建立品牌信任和权威的方法。

利用人类可视性和可信赖的品牌来对抗AI污名

就目前而言,人工智能确实超过了上网人数。尽管如此,仍无法确定未来几年互联网使用情况将如何发展,因此没有理由立即假设这种趋势是不可逆转的,或者它代表着内在的消极趋势。

驳斥网络上如此多的AI流量的负面言论的最佳方法之一是找到一种方法,以恢复人们对Internet上AI使用的触觉。此外,以建立信任的方式使用AI也很重要,并且不会引起错位的担忧。

- 坚持由高度认可和信赖的品牌提供的值得信赖的产品和服务。想知道哪个标准使卖方“受信任”?我们的指南回答了这个问题。

- 遵守道德规范。不要通过忽略网站上的robots.txt文件来滥用信任,也不要在很短的时间内用大量的漫游器淹没该网站。

- 以负责任和专业的方式使用数据。验证您是否有权将剪贴数据用于您的预期目的。

- 内容丰富。谈论如何以及为什么通过网络抓取来建立公众意识。其他人越了解使用AI来访问和研究海量数据的好处,就越不可能总是从负面的角度来看待爬虫和机器人。

结论

尽管通过纯粹的人工手动访问网站数据是理想的选择,但有太多的信息无法使之成为可行的选择。可用的数据量实际上是无限的,并且AI是我们浏览网站和尽可能高效地分析其数据的最佳方法。

对于打算充分利用其网络抓取努力的数据科学家和其他专业人员,我们强烈建议使用可靠的代理,因为当您访问分析工作所需的信息时,它们可以保护您的身份和隐私。福州软件开发