随着对话语言界面开始主导客户服务,对聊天机器人的强烈反对也随之增加。Forrester去年预测,2019年将是对效率低下的聊天机器人的强烈反对的一年,而且看起来它们是对的。例如,由开放软件服务公司Acquia委托进行的一项调查分析了北美,欧洲和澳大利亚的5,000多个消费者和500个营销人员的回答,发现45%的消费者发现聊天机器人“令人讨厌”。

同时,不能高估对话式人工智能对当今企业的重要性。如果操作正确,对话式AI可以显着提高您的竞争优势,并从根本上改变企业与客户交互的性质。

根据Gartner的数据,到2021年,超过50%的企业每年在机器人和聊天机器人创建上的支出将超过传统的移动应用程序开发。到2022年,聊天机器人预计将减少80亿美元的业务成本,到2023年,使用聊天机器人将为企业和消费者节省25亿小时。

到2024年,全球聊天机器人的整体市场规模预计将超过13亿美元。

那么,消费者对聊天机器人越来越不满意的原因是什么?企业如何确保其数字助理对其与客户的关系产生积极影响?

有些原因很简单,众所周知。例如,许多公司在没有提供人为“安全网”的情况下依靠聊天机器人做太多事情(也就是说,如果有需要,可以快速有效地移交给现场代理)。有些聊天机器人太慢而无法响应(有些则异常快)。在其他情况下,聊天机器人的个性与品牌的声音完全不符。一些企业部署了一个半生不熟的聊天机器人,并最终对其客户进行了培训,而这最终往往是致命的错误。

但是,越来越多的客户认为聊天机器人无法交付的一个巨大且很少讨论的原因仅仅是手头任务的复杂性。对话式AI渗透到我们与技术的互动中越多,人们越期望这些互动类似于自然的人类对话,期望对他们自然表达的问题和请求做出明智的回应。但是问题是,一旦您脱离了简单的命令-响应交互,您最终就会陷入人类语言极其复杂的境地。我们完全认为(说话)的事情,甚至是一个三岁大的孩子都能做到的事情,都很难教机器去做。

这是人类语言的一些共同特征,我们每次张开嘴说话时都不会思考,但是对于许多聊天机器人来说,这可能很难做到。

成语

有时,我们使用具有预期含义的单词,但在许多情况下,我们将它们用作习语。习语是一组单词,其含义不能从单个单词的含义中推导出来,而必须记住。

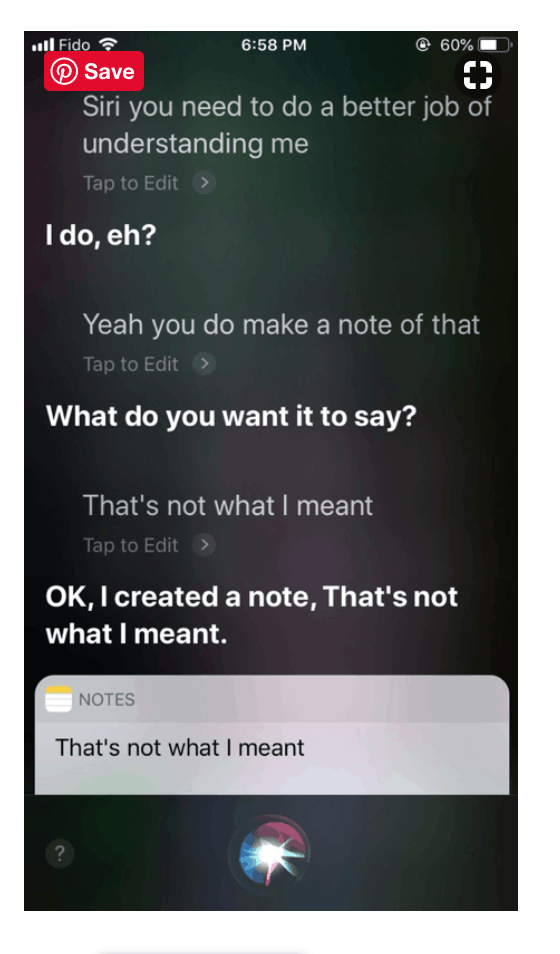

在下面的错误中,Siri从字面上解释了成语“做笔记”,从单个单词的含义中推论出该短语,而此人实际上将其用作表示“记住某事”的表达:

尽管人们依靠上下文和其他提示来确定单词是否被用作习语,但许多聊天机器人却不容易这样做。您只能想象当聊天机器人从字面上解释其他习语时出现的尴尬交互。例如,“让血液沸腾”意为“使某人生气”(医疗聊天机器人会指导您了解症状和病因吗?),“下定决心”,“让您开心”,“正在下雨的猫和狗” ,“断腿”,“悬空”和“小菜一碟”。

代词

可以教授名词,动词和其他词汇项目的含义。但是代词是棘手的,因为它们指的是上下文中先前提到的东西。每个代词都需要一个先行词,即在上下文中前面提到的它所指的实体或个人。但是在某些情况下,可能有不止一个先例,并且侦听器的工作是根据上下文选择正确的一个。

假设您刚离开家去上班,并通过以下请求与您的数字助理联系:

人:关闭客厅的灯,然后关闭咖啡壶

机器人:好的

人类:打开 它回到今天下午6点

第二句话中的“它”是不明确的,因为它可以指代咖啡机或客厅的灯。设计良好的聊天机器人应该能够注意到歧义并提出一个明确的问题。

另一个例子:

“珍妮弗邀请阿曼达去参观,她给她吃了一顿美餐。”

一个人可能会从上下文中弄清楚,这里的“她”很可能是指詹妮弗,而“她的”是阿曼达,这是因为我们知道,发出邀请的人提供晚餐的可能性更大。

现在考虑一下:

“珍妮弗邀请阿曼达去参观,她给了她一条漂亮的项链。”

现在,谁把项链给了谁?与送餐相关的社会习俗要少于晚餐,因此即使是人类,也无法确定此处的意图。

“珍妮弗邀请阿曼达去参观,但她告诉她她要出城了。”

珍妮弗邀请阿曼达来访问,并立即让她知道她当天的旅行计划,这很奇怪。这就是我们知道是阿曼达(Amanda)出城而不能接受邀请的原因。

同样,只有上下文和社会规范的知识才能让我们弄清楚正确的含义,并且您的对话式AI必须足够先进才能学习。

现在,考虑有多少可能来路的代名词是 可以在任何给定的范围内。

“安娜(Anna)告诉布赖恩(Brian),她决定在英国待一年,研究创意写作。”

“ 那将是她一生的工作。” (即创意写作)

“做完这些之后,她会回来和他住在一起。” (那=在英国呆一年)

“ 那是她整整一周都在想的事情”(即决定)

“ 那开始了两个小时的战斗。” (那是告诉布莱恩)”

现在,你会怎么教的平均聊天机器人像那个?

结构歧义

有些含糊是结构性的。例如,句子“鸡肉可以吃了”可能意味着鸡肉在桌子上,或者您需要喂养宠物鸡肉。聊天机器人需要学习很多有关世界以及您的个人情况的背景信息(例如,您个人没有宠物鸡,或者鸡肉是受欢迎的菜,但不是受欢迎的宠物,或者相反)就是您是素食主义者,并且养了一只宠物鸡),以便正确解释它。

当句子包含一个时间性状语和一个以上的动词时,并不总是清楚该状语修饰了哪个动词。

例如,“杰米(Jamie)周五说我们将举行聚会”这样的句子可以表示两件事:

- 杰米(Jamie)周五说,我们将举行一个聚会。

- 杰米说,星期五我们将举行一个聚会。

同样,在自然对话中,人类将具有足够的上下文来确定使用哪种含义,或者知道会提出澄清的问题,但是大多数聊天机器人在出现结构歧义时都无法辨别。

省略

在口头非正式对话中,我们经常忽略一些信息,即我们知道对方可以根据上下文轻松地进行填写。例如,我们可以说“我对乳制品过敏。也是鱼” –可以理解,您对鱼类和奶制品都过敏,而不是对鱼过敏。

有时省略号会引起歧义。例如:

- 迈克爱他的母亲,比尔也爱。(比尔爱麦克的妈妈还是自己的妈妈?)。

- 安娜在她的房间,简也在。(简在安娜的房间里还是在她自己的房间里?)。

更多歧义

在某些情况下,在语音中,我们可以借助韵律提示(语调,语调,音调等)找出歧义句的确切含义。

例如,句子“ 他们正在煮苹果”可能意味着两件事:

- 他们(有些人)正在煮苹果。

- 这些苹果是做饭的。

人类既依靠上下文又可以依靠语调来正确地解释该句子,但是许多聊天机器人无法使用它们。

修辞问题和讽刺

并非每个问题都需要答案。有些问题是修辞性的,只是用来表达说话者的情绪状态,而不是寻求答案。

例如,问题“您知道现在几点吗?” 除非在以下情况下使用,否则通常使用时间说明(“上午11:30”)适当地回答。

“您说我们将在11:00之前到达那里!你知道现在几点吗?”

如果您的聊天机器人以“上午11:30”回答了这个问题,则没有理由不应该将其标记为“烦人”。

此外,如果聊天机器人无法理解客户何时受到讽刺,那么互动将无法顺利进行。例如,想象一下,对于聊天机器人给出的不满意的答案,客户说“这就是我所需要的。我该怎么办?” 如果您的聊天机器人未检测到讽刺语调,但回答“不客气”或尝试回答问题,则该聊天机器人会被认为非常恼人。

幽默中的歧义

最后,幽默可能是使聊天机器人像人一样难以互动的最好例证。在接下来的幽默中,英国喜剧演员吉米·卡尔(Jimmy Carr)利用所提问题的含糊和含糊来营造一种毫无意义的幽默互动:

“前一天,一位拿着剪贴板的女士在街上拦住了我。她说:“您可以花几分钟时间进行癌症研究吗?” 我说:“好的,但是我们不会做很多事情。”

—英国喜剧演员吉米·卡尔

如何避免失误

如今,大多数标准聊天机器人的问题在于,它们出售以“机器学习”作为“银弹”的“ AI”承诺。但是,仅基于机器学习的聊天机器人实质上是黑匣子系统,如果没有大量策划的训练数据就无法工作。如果他们不立即了解您的期望,开发人员就不会轻易对其进行调整或丰富。使他们“改变主意”的唯一方法是添加更多数据。

这些数据不仅需要大量可用,而且还必须准确,分类,机器可读和相关。公司很少会在所有框上打勾,以显示每种语言的所有必要功能。

幸运的是,有一个解决方案。来自人工解决方案的Teneo平台使用一种混合方法,该方法依赖于机器学习和语言学习的结合。

也就是说,它可以利用确实存在的数据,而不必完全依赖于它。语言学习不会像机器学习系统那样使用统计数据。相反,它是一个基于规则的系统,允许人工监督以及对规则和响应进行微调。因此,它可以更好地控制问题的理解方式以及给出的答案。使用语言学习时,如果您希望聊天机器人以不同的方式解释特定的句子,则只需通过重新编程规则即可告诉它(而在机器学习中,需要说服系统通过多次展示来使句子以不同的方式进行解释)反例)。

简而言之,Teneo的语言能力使开发人员可以直接向系统传授正确的响应,然后使用机器学习来完善其性能。正是这种灵活的混合方法使企业能够创建可靠的对话式AI解决方案,以帮助他们建立和改善与客户的关系,而不是破坏它。您将如何构建一个没有被标记为“烦人”的聊天机器人?